Learning Neural Light Fields with Ray-Space Embedding

written by B. Attal, J. Huang, M. Zollhoefer, J. Kopf, C. Kim

@ 第 11 回全日本コンピュータビジョン勉強会 CVPR 2022 読み会

N. Watanabe.

発表者のバックグラウンドについて

- epoch1 (2012-2017): 物理学(場の理論・弦理論、やや数理物理寄り)を専攻(博士号取得まで)

- 理論的な話も大好きですが、簡単な計算機実験(数値計算やモデル学習ではなく、シンボリックな計算)もしてました

- epoch2 (2017-現在): いわゆる受諾分析会社でデータサイエンティスト(未定義)として従事

- 技術領域は、画像認識、自然言語処理が主

- ただ画像解析系はここ1年ほど離れています(最近の流れについていけていない)

- Comptuer Graphicsもド素人

- 小規模(顧客含めて2〜3人) R&D 寄りを担当する事が多め

- 小規模が故に、分析設計・API 開発・運用設計までほぼ1人行う事が多いため、論文調査のウェイトはかなり小さく、業務中はたくさん読んでるわけではない

- 技術領域は、画像認識、自然言語処理が主

Learning Neural Light Fields with Ray-Space Embedding

written by B. Attal, J. Huang, M. Zollhoefer, J. Kopf, C. Kim

@ 第 11 回全日本コンピュータビジョン勉強会 CVPR 2022 読み会

N. Watanabe.

発表者のバックグラウンドについて

- epoch1 (2012-2017): 物理学(場の理論・弦理論、やや数理物理寄り)を専攻(博士号取得まで)

- 理論的な話も大好きですが、簡単な計算機実験(数値計算やモデル学習ではなく、シンボリックな計算)もしてました

- epoch2 (2017-現在): いわゆる受諾分析会社でデータサイエンティスト(未定義)として従事

- 技術領域は、画像認識、自然言語処理が主

- ただ画像解析系はここ1年ほど離れています(最近の流れについていけていない)

- Comptuer Graphicsもド素人

- 小規模(顧客含めて2〜3人) R&D 寄りを担当する事が多め

- 小規模が故に、分析設計・API 開発・運用設計までほぼ1人行う事が多いため、論文調査のウェイトはかなり小さく、業務中はたくさん読んでるわけではない

- 技術領域は、画像認識、自然言語処理が主

紹介論文概要

- 主著者がMetaへインターンに行った時の研究結果

- フォトリアルなView synthesisにおいて、Light Fieldを直接モデル化し、以下を達成(Light Field自体はView synthesisの標準的な手法の1つであるため、全く目新しくないが、温故知新も大事ということで)

- NeRF系に比べてレンダリングが高速 (精度は同程度)

- MPI系(NeXなど)と比べてメモリ効率的な手法(精度はやはり同程度)

- radiance fieldでは不十分な、屈折や反射などもよく表現できる(との主張)

- Light Fieldの汎化困難さに対し、以下2つの技法を提案し、その有効性を評価

- Ray-Space Embeddingと呼ばれる埋め込みを、Positional Embeddingの前に挿入する事で、サンプル間の補間をしやすい構造へマッピング

- 複雑なシーンについても、Subdivisionという空間分割を行う事で精度を担保

- 分割数で、解像度(計算コスト)と精度のトレードオフを制御

選定理由?

客観的理由

NeRFとその派生研究が流行っている(Computer Graphics × 機械学習)

- 免責:発表者は 3D Computer Graphics に詳しい訳ではないため(つい1 ヶ月前まで NeRF 原論文+顔認識系の 3D 構成数本くらいしか読んだ事なかった)、やや理解が浅い箇所もあるかもしれません。気になった箇所は、気兼ねなくご指摘・ご質問ください。

Light Field自体は、Novel View Synthesisに対し、NeRFと異なるアプローチをとっている

主観的理由

(Novel View Synthesisの文脈で) "Light Field" なる単語をたまに見かけるが、何なのか全く知らない

- "Light", "Field"と物理学畑で育った人間に刺さるキーワード

- 数学的観点からも興味深い

今回幾つか読んだ中で、初見では彼らの提案内容(のアイディア)をよく理解できなかった

- せっかく自分なりに解読・再整理したので、発表します

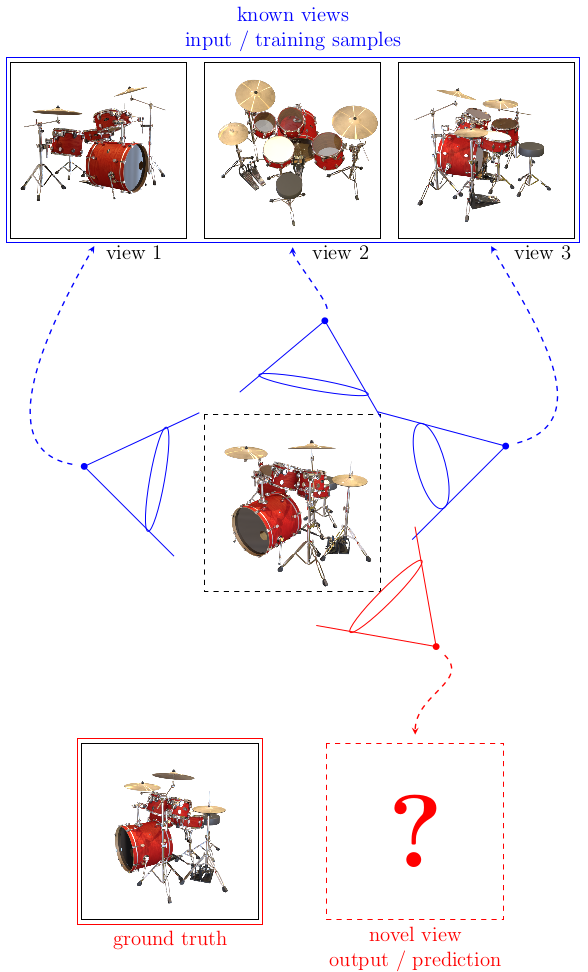

そもそもNovel View Synthesisとは何か?

Novel View Synthesisを訳すと「新規視点の光景を合成」となる。もう少し言葉を補ってやると、これは

- 3 次元世界における、特定の対象に関する撮影・視覚情報が与えられた時に、

- 新しく指定した視点(Novel)からの

- 見え方(View)を

- 特定・合成(Synthesis)する

タスクである。特にここで考えている入出力としては、右図にも示したような

- 入力:幾つかの方向から捉えた既知の光景

- 出力:ある方向から捉えた場合の未知の光景

という形式である。

なお、古くから存在する定番のタスクだと思われるが、 最近のneural networkによるシーン表現の研究と、 2022年のNeRF論文によって、耳目を集めている。

ドラムの各画像は、NeRFの公開データから拝借した。

ドラムの各画像は、NeRFの公開データから拝借した。言葉の定義

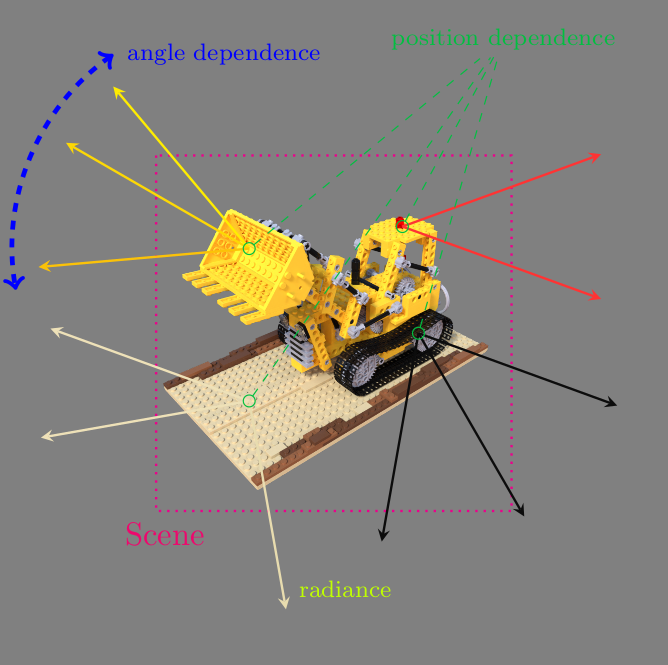

- 『シーン(scene)』 : 3 次元世界・環境を表す情報の内、視覚情報のみに関わる状態を表す

- 多くの場合、どんな色合い&反射特性を持つオブジェクト(表面)が、空間中のどこに存在するか、で指定される

- 『放射輝度(radiance)』 : ある領域から各方向へ、光が放たれる際のその強度

- 3次元空間内の位置に依存するだけでなく、方向・角度依存性も持つ事に注意

- 特にNeRF-familyでは、RGBそれぞれの成分 + 物質密度の形に分解する

- 波数依存性を考慮したものは、『分光放射輝度(spectral radiance)』と呼ばれるが、こちらに近い

- 『場(field)』 : 空間の各点に何かしらの(物理的な)値が付随している状態、あるいはその表現

- 『Radiance field』 : 放射輝度に値を取る場

- 3次元空間の各点に対して付随するため、"物質"が存在しない位置でも値が定義されている

- このradiance fieldから、様々な視点から見える画像を生成するプロセスは、 『ボリュームレンダリング(Volume Rendering)』 と呼ばれている

レゴの画像は、NeRFの公開データから拝借した。

レゴの画像は、NeRFの公開データから拝借した。Radiance Field を用いたボリュームレンダリングの問題点

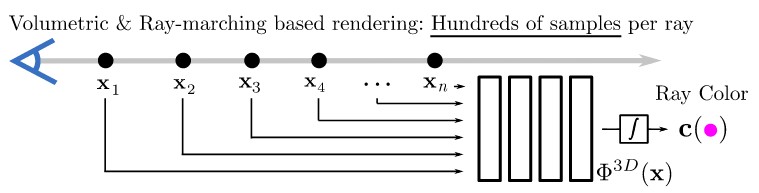

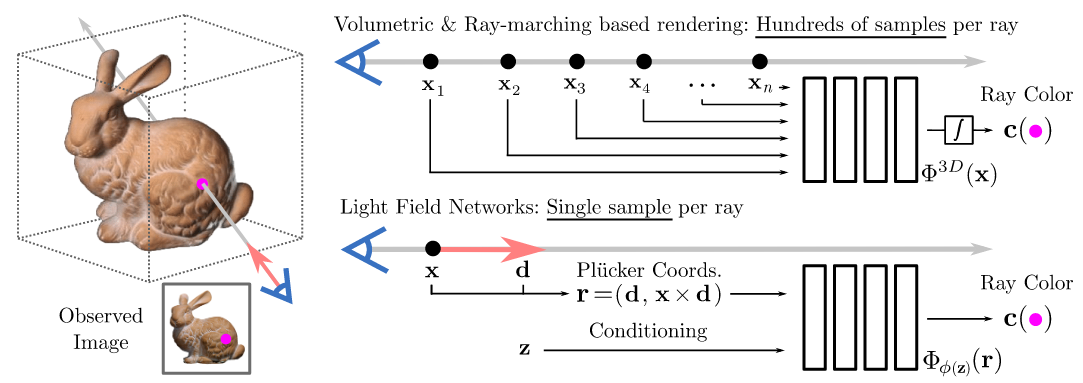

レンダリングプロセス

- 通常Radiance Fieldを用いたボリュームレンダリングに於いては、各視線上、放射輝度の値の分布が利用される

- 言い換えると、viewの1つのピクセルの色を決定するために、そのピクセルを通る視線上の放射輝度の値を、十分なサンプリング数で計算する必要がある

論文[7]より借用

論文[7]より借用計算コストの見積もり

H×Wピクセル程度の新規視点画像を合成する事を考える。 放射輝度分布を知るための、典型的な必要サンプリング数をMとおくと、計算コストのオーダーはH×W×M(要するに、3次元の解像度レベル)になる。

とくにW∼300、H∼300、M∼128∼102とおくと、 H×W×M∼107の放射輝度を評価する必要がある

NeRF-family においては、radiance field をMLP (Multi-Layer Perceptron)でモデル化しているが、 1枚の画像生成のために、このMLPに対する107回のforwarding計算となる。

そのため、一般的に radiance fieldを用いたレンダリングプロセスは高コスト で、リアルタイム計算が難しい。

解決のためのアイディアとLight Fieldの導入

- レンダリングにおいては、シーン中心から外れた、光線上に付随する放射輝度積算結果のみに興味がある。

- よって、シーンから出てくる最終的な放射輝度(光が進んでも値がほぼ変化しない)を直接評価する。

このような、光線毎に付随する積算した放射輝度を表現するものとして、 『Light Field』 と呼ばれるものが知られている。

| 入力 | 出力 | |

|---|---|---|

| Radiance Field (NeRF) | シーン空間の位置と方向 | 各点に付随する放射輝度と密度 |

| Light Field | 光線 | 光線に付随する放射輝度 |

論文[7]より借用

論文[7]より借用Light Fieldに関する言葉の定義と座標系の導入

- 3次元空間における、光線(ray)がなす集合(以降 L とかく)を考え、 『光線空間(ray space)』 と呼ぶ ∗1

- このL上の、放射輝度(色のみ)に値を取る場が、Light Field である ∗2

- 特にこれをNNでモデル化したものを、『Neural Light Field (NLF)』 と呼ぶ。

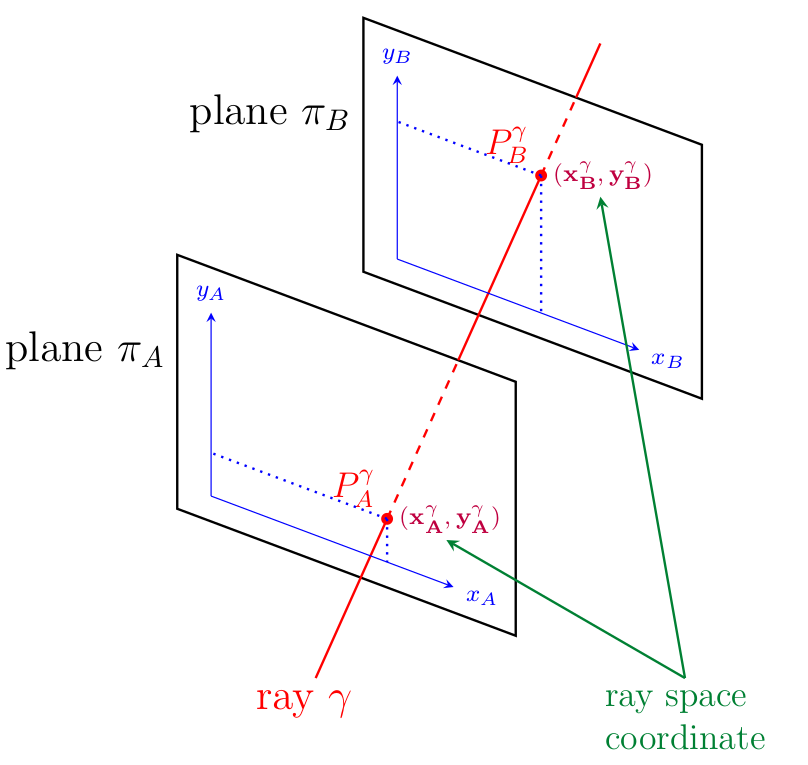

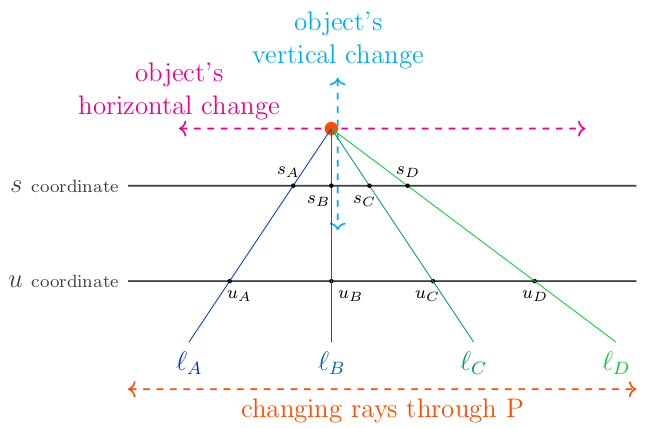

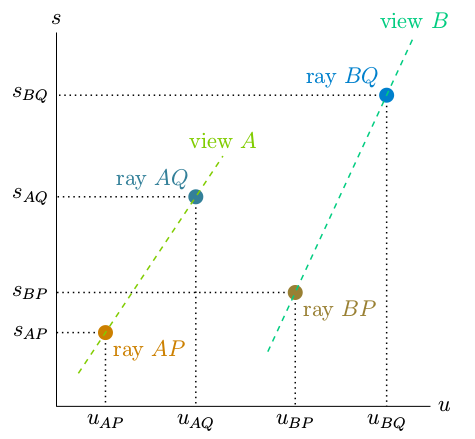

Light Slab:2平行平面を用いた座標系について

右図のように平行な2平面(πA, πBとよぶ) を置き、それぞれに2次元座標系((xi,yi)i=A,B) を設定しておく。 そして各光線 γ と、2平面の交点 (PAγ,PBγ) を考え、 この2交点の各2次元座標の値を集めた、4個の数値 ((xAγ,yAγ,xBγ,yBγ) where wiγ:=wi(Piγ) for w=x,y and i=A,B) を、光線座標(Lの局所座標)とする。

逆に、光線座標の値を与えると、3次元空間中に光線を1つ定める事が分かる。

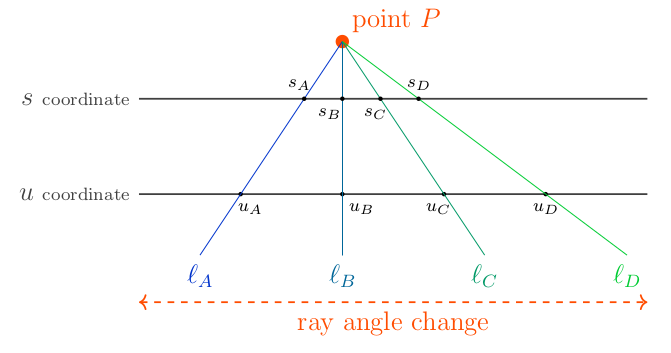

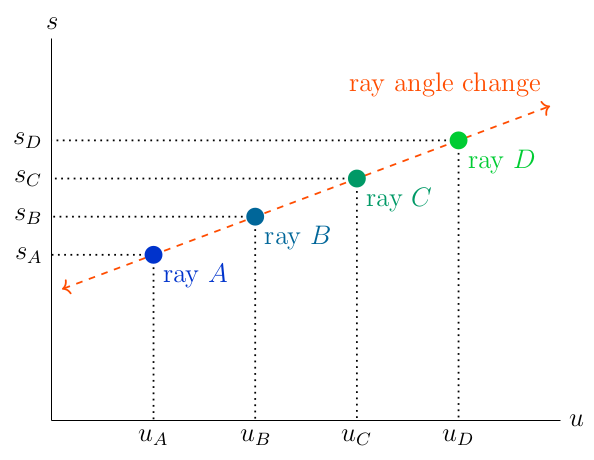

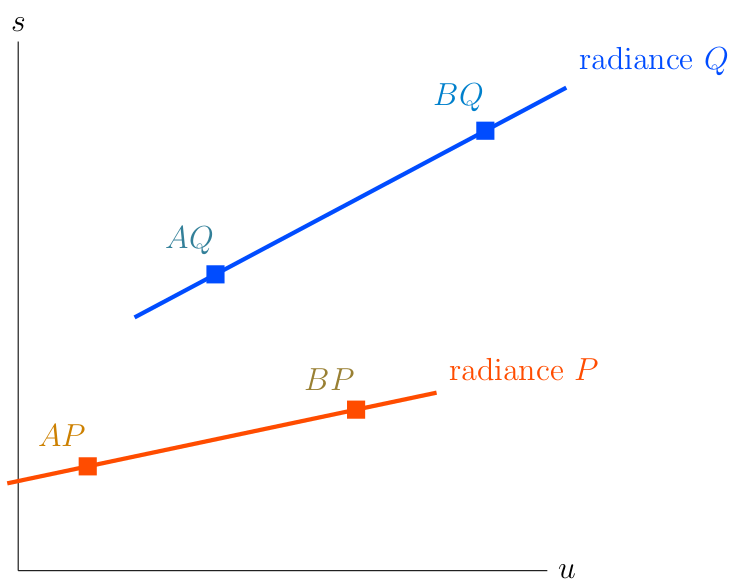

2次元シーン空間に対する光線空間

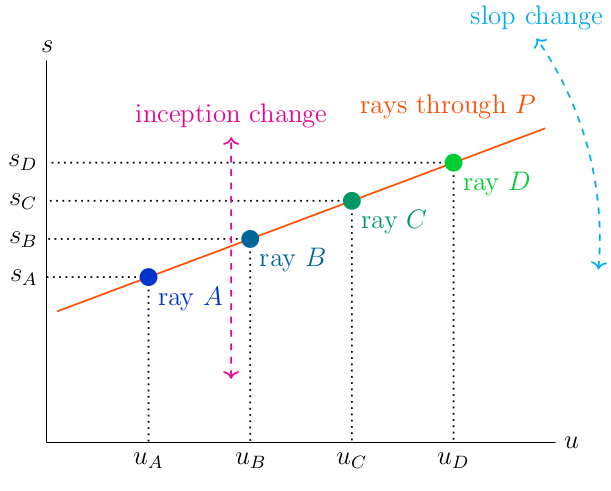

光線空間Lとその上の座標を理解するために、ここでは2次元の世界(以降、シーン空間 Sと呼ぶ)を考える。この時、Lは2次元の空間をなすが、シーン空間と光線空間の間に以下の対応が存在する:

2次元シーン空間 S | ↔ | 光線空間 L |

| 1つの光線(=直線) | ↔ | 1点 |

特定の点を通る光線全体の集合(下図中央) | ↔ | 直線(下図右) ∗1 |

特定の点から出る光線に対し、その角度を変える | ↔ | 直線上を動く ∗∗2 |

2平行"線"座標系

- light slabで導入した2平面は、2次元シーン空間 S だと、2直線になる

- 各slab直線に、s座標とu座標を導入

- 光線空間 L の座標となる

2次元シーン空間 S

対応する光線空間 L (2次元)

シーン空間と光線空間の対応関係(続き)

1つの点オブジェクトが存在するシーンを考え、そこから出ていく光線全体についてもう少し考察する。

- オブジェクトが、slab直線に対し平行に(図面上、水平に)移動する

- この時、光線空間内では直線も平行移動、すなわち、s切片が変わる

- オブジェクトが、slab直線に対し垂直に(図面上、鉛直に)移動する

- この時、光線空間内では、ある点を中心に回転移動、すなわち、直線の傾きが変わる

- 今回の例だと、オブジェクト移動で不変なray B が回転の中心

- オブジェクトが、 s 座標に対応するslab直線上にのる

- 傾きが0、すなわち光線空間において、u 軸に平行な直線となる

ふと我に返る(安直なLight Fieldの学習は困難では?)

これまで見てきたように、Light Field は、光線を入力とし、付随する輝度を返す関数である。 これは視点情報(1点を通る光線の集まり)を入力とすると、対応するview画像(1点に集約していく輝度の集まり)を出力する、とも言えるため、実質的には

view synthesis = Light Field の計算 = Neural Light Field (NLF) の評価

と言える。

特に、未知の視点(novel view)に対して推論可能である事に対しては、

novel view synthesis がうまくいく = NLF が汎化 = 既知のviewからの正しい補間が定められる

となる。

しかし実際問題は、光線空間の背後に隠れてしまった3 次元世界の事前情報を直接活用できていない事もあり、うまい補間を定めるのは難しい、と考えられる。

※そもそもこれが上手く行くなら、(単純な view synthesis において) NeRF なんて複雑なものは要らず、直接解いてしまえばよかったはずである。

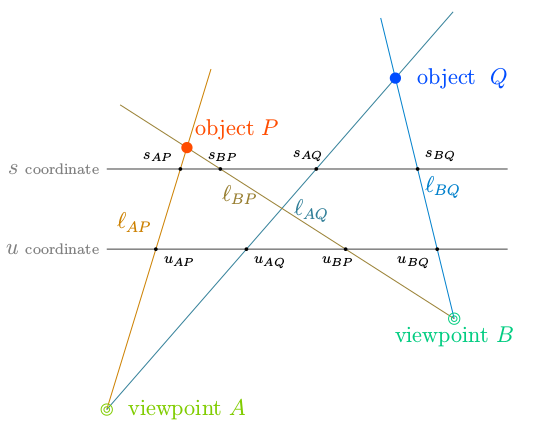

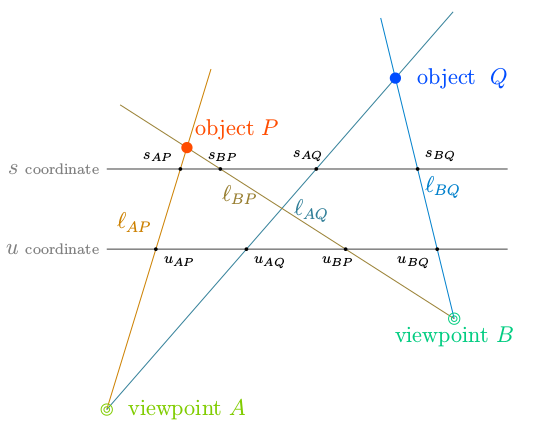

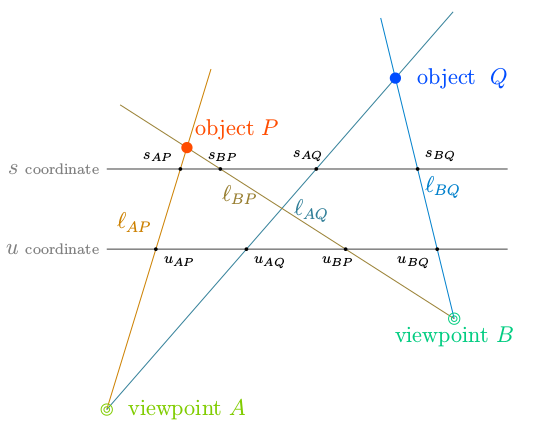

2 次元シーン空間における View synthesis

説明を簡単化するため、引き続き、2 次元シーン世界の view synthesis を考える。

セットアップ

"2"次元シーン空間内のオブジェクトとカメラ配置

- 十分小さな点オブジェクトP, Qが与えられる

- カメラ視点(viewpoint)もA, Bの2つを考える

光線

- 輝度が非自明な光線としては、A-P, A-Q, B-P, B-Qの4つが存在

このセットアップでは、シーン空間と光線空間の対応関係は以下のようになる。

- A-P, A-Q, B-P, B-Qの各光線に対応する点をそれぞれ可視化

オブジェクトを起点とする場合と同様、 カメラ視点から出る全ての視線(光線)の集合も、光線空間上の直線となる。 左図では、それを点線で示した。

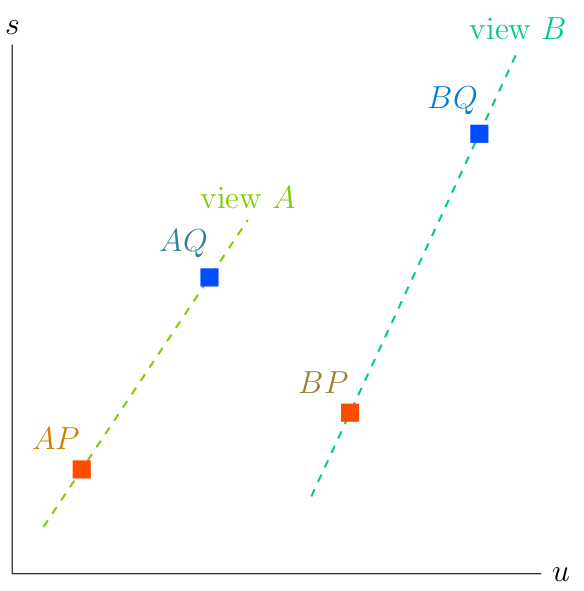

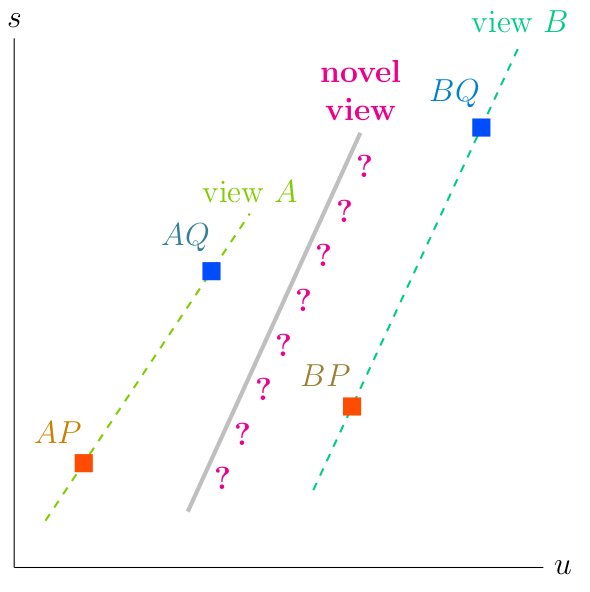

- この時、既知の各光景(訓練サンプル)は、光線空間内の線分上の色分布に他ならない(下図左)

一方で、新規の光景を推論する事は、

- 異なる視点間で、同一オブジェクト由来の輝度の対応付けを行い、

- 視点間の輝度を補間し、新たな線分上の色分布を推定する

事に相等する(下図中央)

| 既知サンプルが与えられた時 (点線が既知) | 未知サンプル(光線)の輝度を推定 | 正解(ground truth) (実線が正しい輝度に対応し、他は0) |

|  |  |

再び3次元写実的な世界へ

先の説明を、より現実的なケースとの対応と共に整理すると、

| セットアップ | 2点のオブジェクトからなる2次元シーン空間 | 多種多様なオブジェクトが存在する3次元シーン空間 |

|---|---|---|

| 光線空間の座標と次元 | 2つの1次元直線座標 → 2次元 | 2つの2次元平面座標 → 4次元 |

| ある点を通る光線全体 | 2次元光線空間上の1次元直線 | 4次元光線空間上の2次元平面 |

| 光線空間上、同一オブジェクト由来の輝度の対応付け | 組み合わせがほとんどないため、簡単 | オブジェクトの表面上、似たような輝度が連続して続くため、対応付け困難 |

| 光線空間上、同一オブジェクト由来の視点補間 | 対応づけした2点間を通る直線を特定するだけ(余次元1) | 対応づけした複数点から平面を保管する必要がある(余次元2) |

となるが、結局、「Neural Light Field (NLF)の汎化」は、

4次元光線空間 L 中、

幾つかの2次元平面上での色分布(=画像)が(既知サンプルとして)与えられた際に、

それらとは異なる新しい2次元平面上の色分布(=新規視点の画像)を補間(=生成)する

事に他ならない。しかし、(3次元世界由来である、という)事前知識なしにこれは難しい。

これを成功させるため、論文では、次に説明するような2つの技法を提案している。

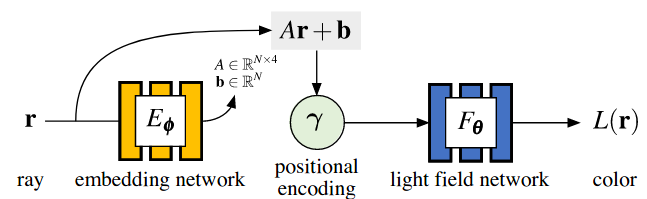

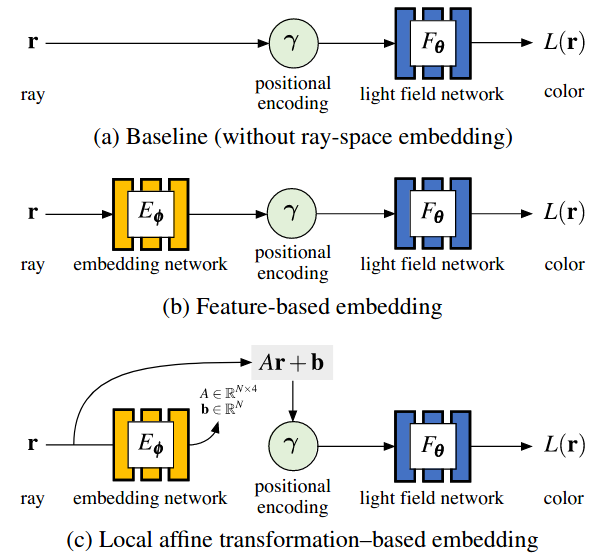

提案技法1. Ray Space Embedding

目的

- 入力情報の効率的な圧縮

- 補間可能な潜在空間

お気持ち・アイディア

- positional encodingは、成分毎に適用されるため、光線空間上の座標軸方向は特別な意味を持つ。

- 2つは光線方向・角度成分、残り2つはテキスチャ成分を検出する。

- 光線空間の各点における、同一点の方位変化方向(傾き)を推定し、これを軸と平行になるよう補正したい。そのためには回転行列を推定して、作用させれば良いが、ここでは一般的化したアファイン変換を推定する。

- 先に述べたように、これは深度推定に相当する。

- 特に光線空間の各点で傾きは異なる(オブジェクトごとに深度が異なる)ため、アファイン変換は局所的(=光線空間上の関数)。

- 推定候補自体は複数用意するため、埋め込み次元は4ではなく、一般に4nと表される。光線座標系を複数設定している事に相等する。

- positional encodingは、成分毎に適用されるため、光線空間上の座標軸方向は特別な意味を持つ。

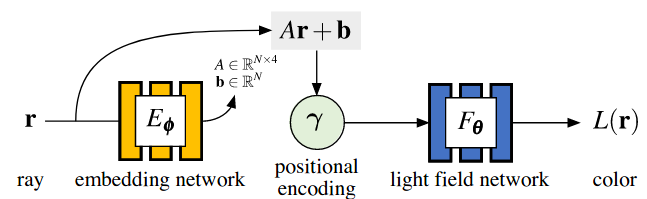

- 定式化:L(r)=Fθ(γ(A(r)r+b(r))) where (A,b)=Eϕ(r)

- r∈R4: 入力。光線空間の座標値

- Eϕ: 局所アファイン変換を推定するネットワーク

- A(r)∈RN×4: 光線空間をN=4n次元潜在空間へ埋め込むための線形変換パート

- b(r)∈RN: 平行移動パート

- γ: positional encoding

- Fθ: 潜在空間を入力とし、色(輝度)を決めるネットワーク (color networkなどと呼ばれている)

対象論文[1]から引用

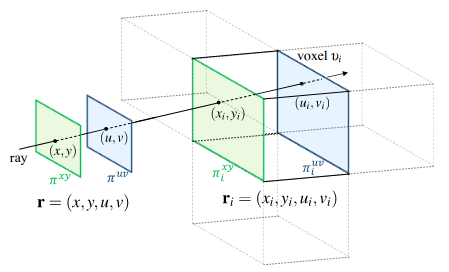

対象論文[1]から引用提案技法2. Subdivision

目的

- 視点に関して疎な状況においても、補間をうまくやりたい

お気持ち・アイディア

- 空間を分割(ボクセル化)し、それぞれにLight stabとLocal Light Fieldを割り当てる

- NeRFとNLFを組み合わせる事に相等し、ボクセルの数分だけ光線空間の座標系が追加される

- 各ボクセルにおいては、対象オブジェクト表面はより平面に近づくので扱いやすい

- 特にボクセル断面と合致すると、傾き推定(深度推定)が自明となる

- ボクセル化に伴って光線も分割され、各分割区間で積算した放射輝度をLight Fieldで評価する

- NeRF同様、密度(=光の放射強度と減衰率)も推定するが、あくまで光線に付随する(積算)密度である事に注意

- レンダリングについても、視線と交差する各ボクセルからの積算放射輝度を、減衰込みで加算して算出

- 空間を分割(ボクセル化)し、それぞれにLight stabとLocal Light Fieldを割り当てる

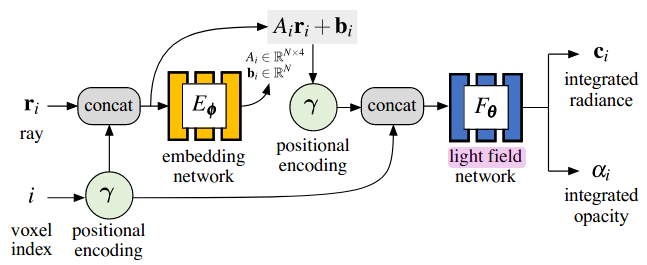

定式化

- i: ボクセルインデックス

- ri: ボクセルiに付随する光線空間の座標

- NNモデルの変更点:双方の入力にボクセルの位置情報の埋め込みが追加

- 局所affine変換の推定:Eϕ:(ri,γ(i))→(Ai,bi)

- Color network:Fθ:(γ(Airi+bi),γ(i))→(ci,αi)

- 輝度に加え、密度αiの推定が加わる

- 光線rに付随する輝度の最終的な計算式: c=∑i∈V(r)(∏j∈V(r)∩j<i(1−αj))αici

- NeRFのボリュームレンダリングとほぼ同じ

対象論文[1]から引用

対象論文[1]から引用 対象論文[1]から引用

対象論文[1]から引用 対象論文[1]から引用

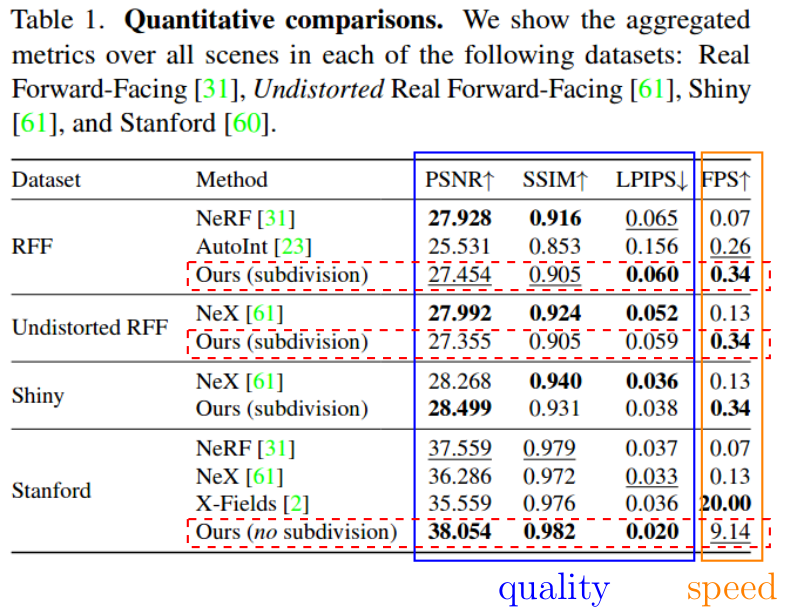

対象論文[1]から引用実験概要と定量比較

- データセット

- Real Forward-Facingとその変種(Undistorted RFF)

- (視点に関し)疎なサンプルを含むデータセット

- Shiny (NeX論文で提案)

- viewの方向・角度依存性を評価するため、反射や屈折のある画像を含むデータセット

- Stanford Light Field

- (視点に関し)密なサンプルを含むデータセット

- Real Forward-Facingとその変種(Undistorted RFF)

- 評価指標

- 精度:PSNR, SSIMに加え、近年のNVSでよく使われるLPIPSを採用(定義は割愛)

- 推論速度としてFPS

- 比較結果

- 精度:既存手法と遜色ないレベル

- 推論速度:NeRFの5〜100倍、X-Fieldを除き、疎な補間で数倍程度、密な補間だと100倍近い改善

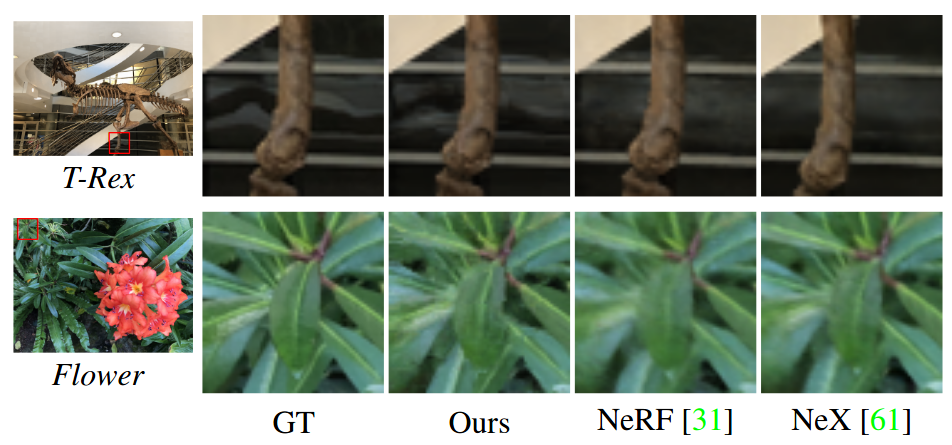

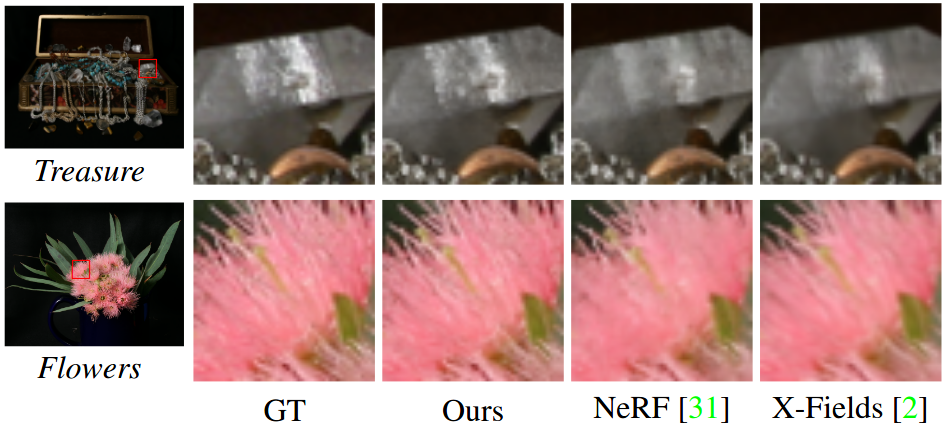

定性比較:デモ動画

以下は、著者らのHPに掲載されている比較である。 著者らは違いを赤い枠で囲み強調しているが、正直、見た目に違いはほとんどない…

| Ground Truth (Nearest) | NeRF | X-Field | NLF |

taken from https://neural-light-fields.github.io/

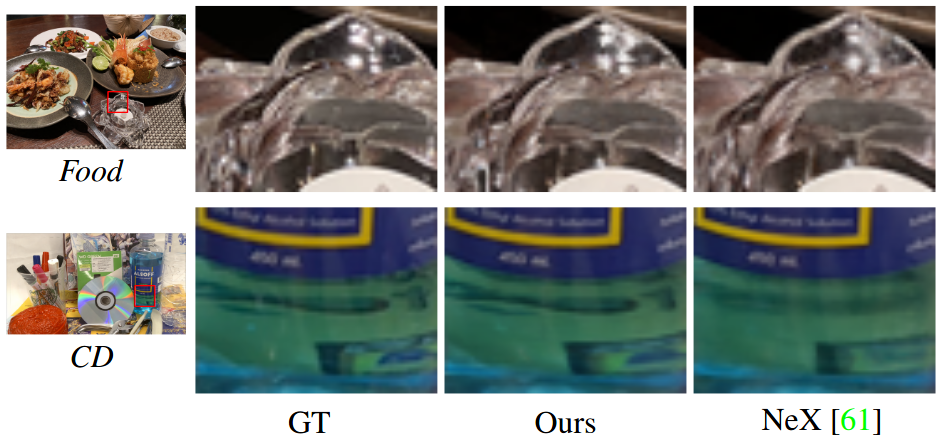

定性比較:view-dependence

著者らは、本手法による視点依存性の改善を強調しており、以下のような結果を提示している。 実際、専攻研究よりも鮮明さはあるように見える。(が、view-dependenceの改善については、この可視化からは分からないように見える)

|  |

|

|

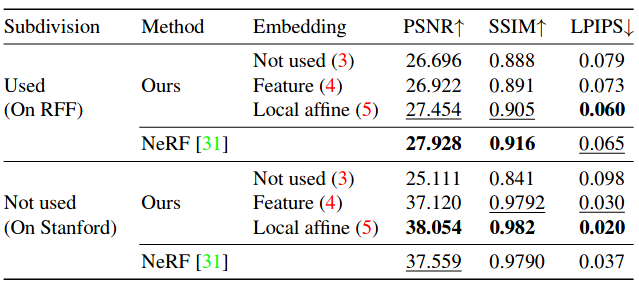

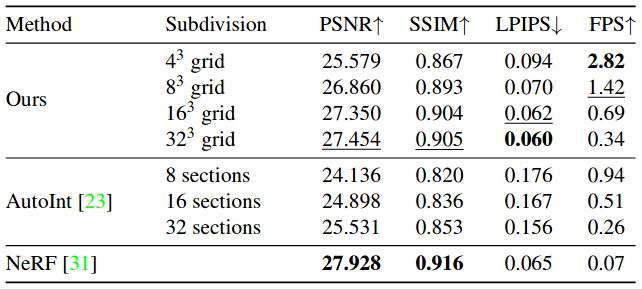

Ablation study

- "Feature"は光線空間座標をMLPで直接埋め込む場合

- "Local affine", "Feature", "Not Used"の順に良い

- 特に"Not Used"は、Standford データセット(サンプルが視点間に対し密)では大きな差が出ている

- 推論速度(FPS)は、グリッド分割数(細かさ)に反比例する

- ボクセルが粗いほど、推論速度が速い

- 放射輝度サンプル数〜グリッド分割数になる事から推察可能

- 細かいほど精度が上がるが、16->32だと伸びは小さい

- 推論速度と精度はトレードオフ

細かい補足

訓練時間

| モデル | 詳細 | データセット | 訓練時間 |

|---|---|---|---|

| NLF | subdivisionあり(323 resolution) | RFF, Shiny(視点に関し疎なデータセット) | 約20時間 |

| NLF | subdivisionなし | Stanford(視点に関し密なデータセット) | 約10時間 |

| NeRF | 各データセット | 約18時間 | |

| NeX | 各データセット | 約36時間・2GPU |

アーキテクチャ

- 光線空間の埋め込み次元:N=32

- positional encoding γ

- subdivided version: L=8

- no subdivision: L=10

- 埋め込みモデルEϕ・LFネットワークFθ:共に 8 layer, 256 hidden unit MLPで、1つのskip connectionをもつ

制限

- 360∘ シーンで同様の事をしようとすると難しい

- Light slabは使えず、代わりにPlu¨cker座標を使用

- この座標系では、決まった点を通る光線集合は平面にならないため

- 現状、subdivisionと組み合わせないと、視点について疎なケースでは十分な精度が出ないが、元の問題であった推論速度低下につながる

まとめに代えて

所感・感想

- Light Field単体でも工夫すれば、思いの外学習ができる事は意外だった

- ただしオリジナルのNeRFを中心に比較しており、精度面でも速度面でも進化していると思われるので、どの程度優位性があるかは不明

- 例えば、FasterNeRF(文献[10])では精度を落とさず、200FPS程度まで高速化している、との記載がある

- また提案技法の内容も「お気持ち・アイディア」から実際の「定式化」まではややギャップがあるように思われる

- アーキテクチャは複雑になるが、同じCVPR2022のLF Neural Rendering(文献[2])の方が、補間時に、同一オブジェクトの情報を参照するためにepipolar line/pointsを利用していて、自然に感じる

- 全体としてややネガティブな印象となってしまったが、Light Fieldの可能性を感じさせてくれる論文ではあった

疑問点

- local affine 変換の推定結果から、実際に深度の情報が取り出せるのか?

- sceneの照明条件変更などの拡張はできるのか?

- 事前に NeRF で学習を行い、推論はLFN に蒸留してから行う手法があっても良さそう

- と思っていたら、実は文献[11] (R2L)がまさにその研究であった

- 3 次元情報の取り込みを、local affine 変換の推定と、subdivision で吸収しているが、より explicit に 3 次元情報を取り込めないか?

- Light FieldがGrassmann 多様体上の関数である事をうまく使えないか?

参考文献

B.Attal, J-B.Huang, M.Zollhöfer, J.Kopf, and C.Kim, "Learning Neural Light Fields with Ray-Space Embedding". CVPR2022 (今回の論文)

B.Mildenhall, P.P.Srinivasan, M.Tancik, J.T.Barron, R.Ramamoorthi, and R.Ng. "Nerf:Representing scenes as neural radiance fields for view synthesis". ECCV2020

M.Suhail, C.Esteves, L.Sigal, and A.Makadia, "Neural Light Field Rendering". CVPR2022 (Best paper finalist)

F.Dellaert and L.Yen-Chen, "Neural Volume Rendering: NeRF And Beyond". 2101.05204 (NeRFのサーベイ)

A.Tewari, J.Thies, B.Mildenhall, P.Srinivasan, E.Tretschk, et.al. "Advances in Neural Rendering". 2111.05849, State of the Art Report at EUROGRAPHICS 2022 (Neural renderingのレビュー)

Y.Xie, T.Takikawa, S.Saito, O.Litany, S.Yan, et.al. "Neural Fields in Visual Computing and Beyond". 2111.11426 (Neural Fieldsのレビュー)

V.Sitzmann, S.Rezchikov, W.T.Freeman, J.B.Tenenbaum, and F.Durand, "Light field networks: Neural scene representations with single-evaluation rendering". NeurIPS2021

M.Levoy and P.Hanrahan, "Light field rendering". In Proceedings of the 23rd annual conference on Computer graphics and interactive techniques, 1996

M.Tancik, P.P.Srinivasan, B.Mildenhall, S.Fridovich-Keil, and N.Raghavan el.al. "Fourier featureslet networks learn high frequency functions in low dimen-sional domains". NeurIPS2020

S.J.Garbin, M.Kowalski, M.Johnson, J.Shotton, and J.Valentin, "Fastnerf: High-fidelity neuralrendering at 200fps". ICCV2021

H.Wang, J.Ren, Z.Huang, K.Olszewski, M.Chai, Y.Fu, and S.Tulyakov, "R2L: Distilling Neural Radiance Field to Neural Light Field for Efficient Novel View Synthesis". arXiv:2203.17261[cs.CV], ECCV2022

mebiusbox, 『基礎からはじめる物理ベースレンダリング』. https://zenn.dev/mebiusbox/books/619c81d2fbeafd, 2021

山内, 『三次元空間のニューラルな表現とNeRF』. ALBERT Official Blog, https://blog.albert2005.co.jp/2020/05/08/nerf/, 2020

金谷, 菅谷, 金澤, 『3次元コンピュータビジョン計算ハンドブック』. 森北出版, 2016

加藤, 『微分可能レンダリング』. https://speakerdeck.com/hkato/wei-fen-ke-neng-rendaringu-cvimyan-jiu-hui-tiyutoriaru, CVIM&PRMU研究会チュートリアル, 2022

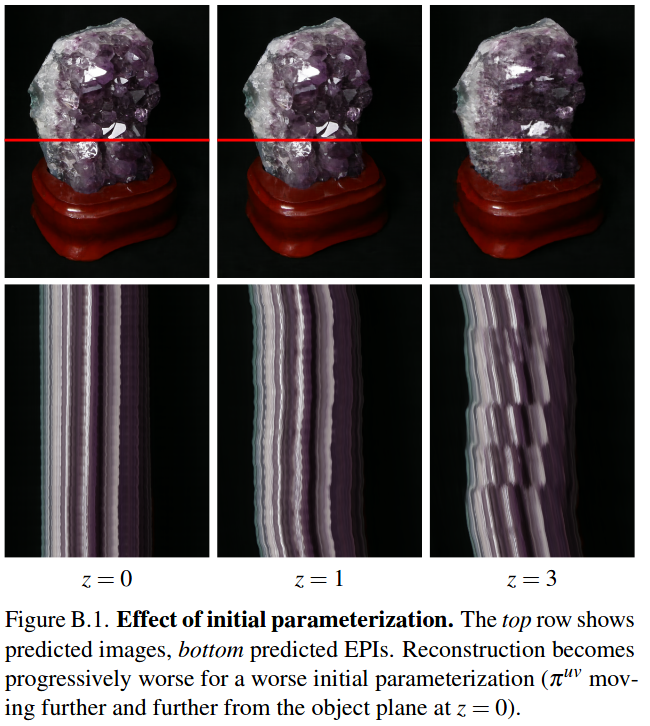

Light slabとオブジェクトの位置関係に関する定性評価

- Light Slabの深度と、オブジェクトの深度の関係を幾つか変えた時に、学習後の推論結果がどう変わるか、を評価

- Light slabとオブジェクトの深度が一致している時、z=0

- 離れるにつれ、zの値が大きくなる

- 結果

- z=0の時は、綺麗に補間できている

- z=3の時、EPIがガタガタ(=正しく補間できていない)

- 非Lambert反射・屈折がない状況では、まっすぐなタイル積算型(ただし斜めでよい)になる

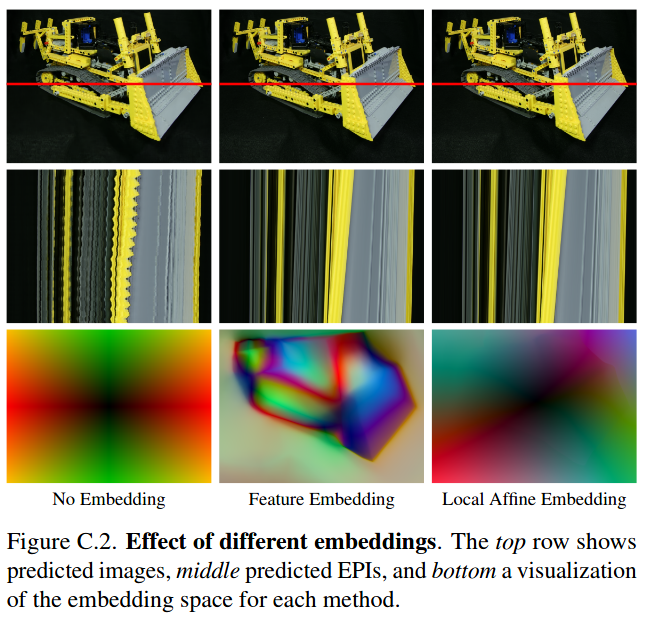

埋め込み空間の可視化

- 埋め込みなし(Not Used)、MLPで直接埋め込み(Feature)、局所ファイン変換を推定して埋め込み(Local Affine)の3つのケースについて、学習後の推論結果がどう変わるか、を評価

- 2枚目がEPI、3枚目が埋め込みベクトルの主成分top 3をRGBで可視化

- 結果

- Not Usedとは、EPIがガタガタ(=正しく保管できていない)

- Featureの場合は、光線空間内を動いた時の、埋め込みベクトルの変化がガタガタ(解釈不明)になっている

- Local Affineは、Light Field中間層におけるある種の正則化と思える?